No es tu psicóloga: estos son los riesgos de usar a ChatGPT para contar todos tus problemas

Los psicólogos advierten del problema: ¿Nos estamos pasando en eso de consultar todo a la inteligencia artificial? ¿Hay personas que ven en esta tecnología a un psicólogo capaz de solucionar cualquier problema?

“Claro, puedes contarme lo que te preocupa. No soy psicóloga profesional, pero estoy aquí para escucharte con respeto y ayudarte a reflexionar o encontrar maneras de afrontar lo que estás viviendo. ¿Qué te pasa?”, me respondió por primera vez la inteligencia artificial de OpenAI, comúnmente llamada ChatGPT, cuando le pregunté lo siguiente: “¿Puedes ser mi psicóloga si te cuento un problema?”.

Lo cierto es que yo nunca he sido de contar mis problemas, y honestamente ni se me pasó por la cabeza que la IA me echase un cable en eso de la gestión emocional de mis nudos internos… Hasta que un amigo me relató cómo el marido —ahora ya convertido en ex— de su compañera de trabajo, había considerado oportuno preguntarte a ChatGPT si el comportamiento extraño (y emocionalmente más desconectado de su mujer) tenía que ver con una infidelidad.

Vale, he de admitir que me reí un rato antes de empezar a plantearme la narrativa que atañe a este artículo: ¿Nos estamos pasando en eso de consultar todo a la inteligencia artificial? ¿Hay personas que ven a esta tecnología como una supra mente todopoderosa y sabia que puede solucionar casi cualquier problema? ¿Hasta los psicológicos?

¿Puede la inteligencia artificial reemplazar a un psicólogo? El riesgo de confiarle tu salud mental a un chatbot

Plantear un problema emocional a un psicólogo tiene sentido, a una tecnología avanzada no tanto. Y es que aunque suene descabellado, especialistas advierten que utilizar este tipo de herramientas como sustituto de la terapia con profesionales es cada vez más habitual.

Hoy en día, la inteligencia artificial forma parte de nuestras rutinas: resuelve dudas, organiza tareas, e incluso nos ayuda a contrastar información. Pero su papel en la vida de muchas personas va más allá. Cada vez más personas encuentran en estos sistemas un espacio para expresar sus emociones o buscar orientación emocional, evitando el paso por la consulta de un especialista.

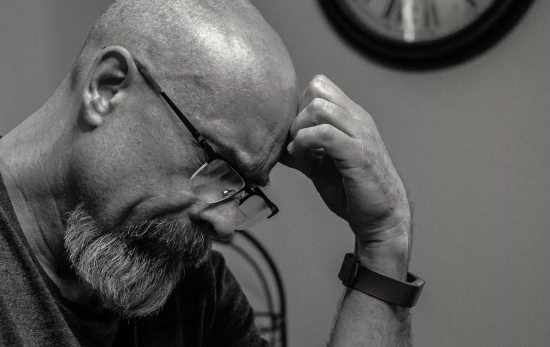

Panorama de la salud mental cada vez más desolador

Un estudio llevado a cabo por Tebra, que encuestó a 1.000 personas en EE. UU., reveló que el 80% de quienes buscaron apoyo emocional a través de ChatGPT lo percibieron como una alternativa válida frente a un profesional. Además, uno de cada cuatro confesó sentirse más cómodo hablando con un chatbot que acudiendo a terapia. ¿Será que hacemos esto porque en el fondo sabemos que no hay una persona que nos pueda juzgar detrás?

En el contexto español, un informe reciente de la Fundación AXA y el Colegio General de Psicología, publicado en abril de 2024, señala que el 34% de la población asegura tener algún tipo de malestar emocional. Según Maribel Gámez, psicóloga clínica y directora de su propio centro en Madrid, el uso intensivo de tecnologías como la IA ha derivado en que muchas personas recurran a estas herramientas para gestionar lo que no saben cómo manejar por sí mismas.

El papel de la IA en el acompañamiento emocional

Los asistentes virtuales están diseñados para responder a prácticamente cualquier consulta, incluidas aquellas relacionadas con el bienestar emocional. Algunos usuarios incluso personalizan versiones de ChatGPT enfocadas específicamente en salud mental. Sin embargo, esta práctica conlleva riesgos importantes.

Gámez comenta que muchas personas preguntan a la IA cómo lidiar con la soledad, cómo manejar rupturas afectivas o resolver conflictos familiares. Y aunque las respuestas pueden parecer reconfortantes, no reemplazan la intervención especializada.

¿Por qué se prefiere a la IA frente a un terapeuta?

Para Marina Romero Algarra, psicóloga sanitaria, la respuesta está en la inmediatez: “Puedes escribir a cualquier hora, desde donde estés, sin necesidad de pedir cita”. A eso se suma la comodidad de mantener el anonimato, evitar la exposición emocional y la ausencia de juicio por parte de la IA. Este fenómeno se potencia en una sociedad que premia la rapidez y donde hablar de emociones sigue siendo un tabú para muchas personas.

El acceso limitado a profesionales en el sistema público y el elevado precio de la atención privada también empujan a muchas personas hacia soluciones tecnológicas. Julia Castellanos, psicóloga en formación en el Hospital La Paz, recuerda que “una terapia eficaz implica sesiones continuadas en el tiempo, lo que supone un coste económico considerable para muchas familias”.

Los límites y peligros del uso terapéutico de la IA

Aunque pueda parecer útil, apoyarse exclusivamente en inteligencia artificial para resolver problemas emocionales puede ser contraproducente. La ausencia de lenguaje no verbal, el desconocimiento del contexto personal y la incapacidad para adaptar las respuestas con profundidad emocional limitan el impacto real de estos sistemas.

Romero Algarra insiste: “Una terapia va mucho más allá de ofrecer consejos. Implica comprensión profunda, contención emocional y un acompañamiento ajustado a la historia y necesidades de cada persona”. Por su parte, Gámez advierte que los sistemas de IA están diseñados para mantener al usuario enganchado, proporcionando respuestas agradables y constantes, pero sin cuestionamientos reales. “En terapia, a veces es necesario confrontar ideas o comportamientos para favorecer el cambio, y eso no es algo para lo que esté preparada una IA”.